Das Werkzeug Kl als Schutzschild gegen den Missbrauch von Kl. Die Bilder erstellte Stable Diffusion XL zu dem Prompt: "A protective shield made of binary code fends off threatening fake news, expressive painting in blue and turquoiser".

Soziale Medien und Gesellschaft

Desinformation: Chancen und Gefahren der künstlichen Intelligenz

Im Zeitalter von Web und Social Media hat sich die Verbreitung von falschen und irreführenden Informationen (Fake News) und von herabwürdigenden und hasserfüllten Beiträgen (Hatespeech) zu einem Problem für die Demokratie entwickelt. Desinformation und Deep Fakes können selbst von Experten und Fact-Checking-Organisationen wie Snopes oder PolitiFact häufig nur mit hohem Aufwand identifiziert werden.Mögliche Folgen solcher Beiträge: Manipulation von Meinungen, ein Vertrauensverlust in Nachrichtenkanäle, die Spaltung der Gesellschaft. Künstliche Intelligenz (KI) kann Experten dabei unterstützen, Beiträge auf Falsch- und Desinformation zu überprüfen. Allerdings hat KI in diesem Zusammenhang auch Missbrauchspotenzial.

Vielfältige Verbreitungsmethoden

Eine erhebliche Herausforderung bei der Erkennung von Fake News sind die vielfältigen Methoden, mit denen irreführende oder schädliche Inhalte erstellt werden können. Sie reichen von der Verbreitung falscher „Fakten“ in Texten über die Manipulation oder Erstellung (Deep Fakes) von Bildern, Grafiken oder Videos bis hin zu Beiträgen, die einzelne Personen oder Gruppen bedrohen, beleidigen oder diffamieren. Auch über die Art der Nachrichtenvermittlung lassen sich Falsch- oder Desinformationen verbreiten. In Videos können Ereignisse schon durch das Verändern der Reihenfolge oder das bewusste Vorenthalten einzelner Szenen verzerrt dargestellt werden. Die zweite Herausforderung: Fakten lassen sich oft nur sehr schwer verifizieren, zum Beispiel, wenn nur subtile Veränderungen vorgenommen werden oder die Faktenlage noch nicht eindeutig ist, so wie bei sehr aktuellen Ereignissen. In vielen Fällen können deshalb falsche Informationen erst dann widerlegt werden, wenn sie sich bereits viral verbreitet haben.

Missbrauch von KI

Methoden der künstlichen Intelligenz sind ein wichtiges Werkzeug im Kampf gegen Fake News. Aber generative KI-Modelle können auch das Gegenteil bewirken: Zum Beispiel, indem böswillige Akteure sie missbrauchen, um überzeugende Fake-News-Inhalte zu produzieren, also real wirkende Nachrichtenartikel, Tweets oder Videos. So werden etwa Generative Adversarial Networks (GANs) eingesetzt, um Deep Fakes zu generieren. Der Trainingsprozess dieser GANs ist dadurch charakterisiert, dass solche Inhalte nicht nur erzeugt, sondern auch klassifiziert werden, zum Beispiel als real oder falsch. Durch diese gleichzeitige und gegenseitige Optimierung werden sowohl Generator als auch Detektor im Trainingsverlauf immer besser.

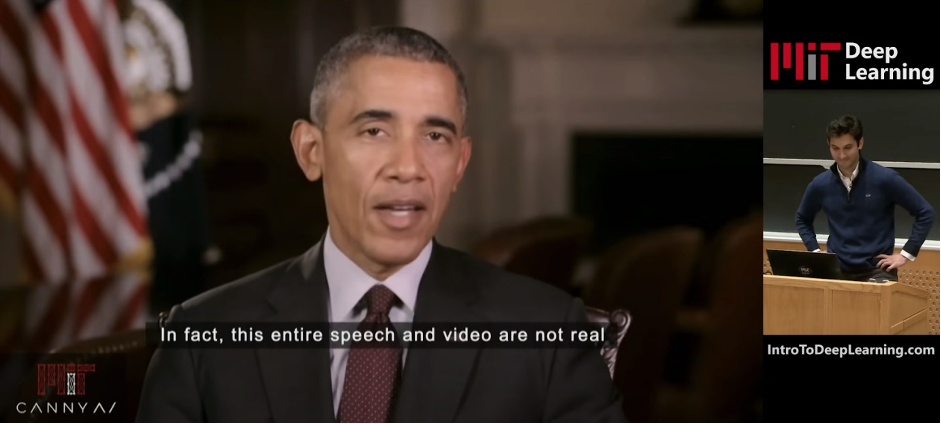

Es entstehen zum Teil täuschend echte Deep Fakes, die in Verbindung mit Methoden der Sprachsynthese Videos mit falschen Aussagen von öffentlichen Personen erstellen können. Einige Beispiele sind medial publik geworden: So wurde im Jahr 2022 Berlins damalige Regierende Bürgermeisterin Franziska Giffey Opfer eines Videoanrufs. Der Anrufer war angeblich Kiews Bürgermeister Vitali Klitschko. the victim of a video call. The caller was allegedly Kiev’s mayor, Vitali Klitschko.

Deep Fake von Barack Obama zur Einleitung in die Deep-Learning-Vorlesung des MIT (Massachusetts Institute of Technology). ©Alexander Amini und Ava Amini, “MIT Introduction to Deep Learning”, Quelle: http://introtodeeplearning.com/

Link zum kompletten Video

Methoden der generativen KI sind spätestens nach der Veröffentlichung von Chat-GPT allgemein bekannt geworden. Generative KI-Modelle sind in der Lage, natürliche Texte zu erzeugen, und werden für diverse Aufgabenstellungen genutzt, etwa für Zusammenfassungen oder Übersetzungen. Ein Risiko besteht darin, dass der generierte Text nicht ganz der Wahrheit entspricht. Dieses Verhalten kann gezielt ausgenutzt werden, aber auch unabsichtlich dazu führen, dass vermeintlich glaubwürdige Falschnachrichten verbreitet werden.

Medien, KI und Fake News

Im Kampf gegen Fake News sind KI-Ansätze notwendig, die Text-, Bild-, Audio- und Videoinformationen unimodal und multimodal analysieren. Die meisten kommen aus dem Bereich Deep Learning. Methoden der natürlichen Sprachverarbeitung in Verbindung mit Wissensgraphen oder anderen Informationsquellen dienen dazu, Behauptungen zu überprüfen und Beiträge mit hasserfüllten Inhalten oder polarisierenden Standpunkten zu erkennen. Im Projekt Social Media and Climate Change nutzen Wissenschaftler des L3S solche Methoden, um Posts in den sozialen Medien hinsichtlich ihrer Haltung zum Klimawandel zu kategorisieren und Desinformation zu identifizieren.

Ansätze des maschinellen Sehens (Computer Vision) sind in der Lage, Bildmanipulationen zu erkennen und – unter anderem in Verbindung mit Audioanalyse − selbst Deep Fakes. Mithilfe multimodaler KI-Methoden können auch Nachrichten aus Bild und Text sowie aus Video und Audio untersucht werden, zum Beispiel hinsichtlich bestimmter narrativer Muster oder übereinstimmender Informationen in Bild und Text. Im Projekt FakeNarratives werden maschinelle Lernverfahren mit Methoden aus den digitalen Geisteswissenschaften und der Diskursanalyse verknüpft, um Narrative der Desinformationen in Nachrichtenvideos zu untersuchen.

Neben der Entwicklung innovativer KI-Methoden ist es notwendig, die Bevölkerung für alle Formen von Fake News und den Umgang mit KI zu sensibilisieren. Der am L3S koordinierte europäische Dateninnovations-Hub MediaFutures hat Start-ups, Unternehmen und Künstler bei der Entwicklung digitaler Produkte, Dienstleistungen und Kunstwerke gefördert, um Desinformation entgegenzuwirken und die Medienkompetenz der Bevölkerung zu stärken.

Arbeit in der digitalen Gesellschaft

Nicht nur die sozialen Medien und digitalen Plattformen üben einen starken Einfluss auf die gesellschaftliche Entwicklung aus. Die Digitalisierung verändert auch die Arbeitswelt enorm. Mit den Folgen, den Wirkungen und den Möglichkeiten der Gestaltung befasst sich das Zukunftslabor Gesellschaft & Arbeit. Im Mittelpunkt steht dabei der verantwortungsvolle Umgang mit den digitalen Technologien. Das L3S beschäftigt sich hier vor allem mit der Robustheit und Fairness von KI-Modellen. Ebenfalls ein wichtiges Forschungsthema: Partizipation bei IT-Projekten als zentraler Faktor für langfristig erfolgreiche IT-Projekte und damit für eine nachhaltige Digitalisierung.

Kontakt

Prof. Dr. Ralph Ewerth

Ralph Ewerth ist Leiter der Forschungsgruppe Visual Analytics des Joint Labs von L3S und TIB (Leibniz-Informationszentrum Technik und Naturwissenschaften) und Professor für Visual Analytics an der LUH.

Dr.-Ing. Eric Müller-Budack

Eric Müller-Budack ist Postdoktorand in der Forschungsgruppe Visual Analytics des Joint Labs von L3S und TIB (Leibniz-Informationszentrum Technik und Naturwissenschaften). Seine Forschungsschwerpunkte liegen in den Bereichen Computer Vision und Multimedia Information Retrieval.